Antes de falarmos sobre inteligência artificial , vale entender o que é inteligência natural — aquela que nós, seres humanos (e outros animais), possuímos. Trata-se da capacidade de pensar, aprender com a experiência, resolver problemas, adaptar-se a novas situações e tomar decisões de forma autônoma. A inteligência natural é resultado da evolução biológica e do funcionamento do cérebro, com suas redes neurais complexas. A IA busca justamente simular essa capacidade cognitiva por meios computacionais, tentando replicar — de forma limitada — a flexibilidade e adaptabilidade do pensamento humano.

A inteligência artificial (IA) está cada vez mais presente no nosso dia a dia — em assistentes virtuais, recomendações de filmes, diagnósticos médicos e até carros autônomos. Mas você sabe realmente o que é IA e como ela funciona?

Inteligência Artificial (IA) é o campo da ciência da computação que busca desenvolver sistemas capazes de simular comportamentos inteligentes. Isso inclui resolver problemas, tomar decisões, reconhecer padrões e aprender com experiências — competências antes exclusivas dos humanos.

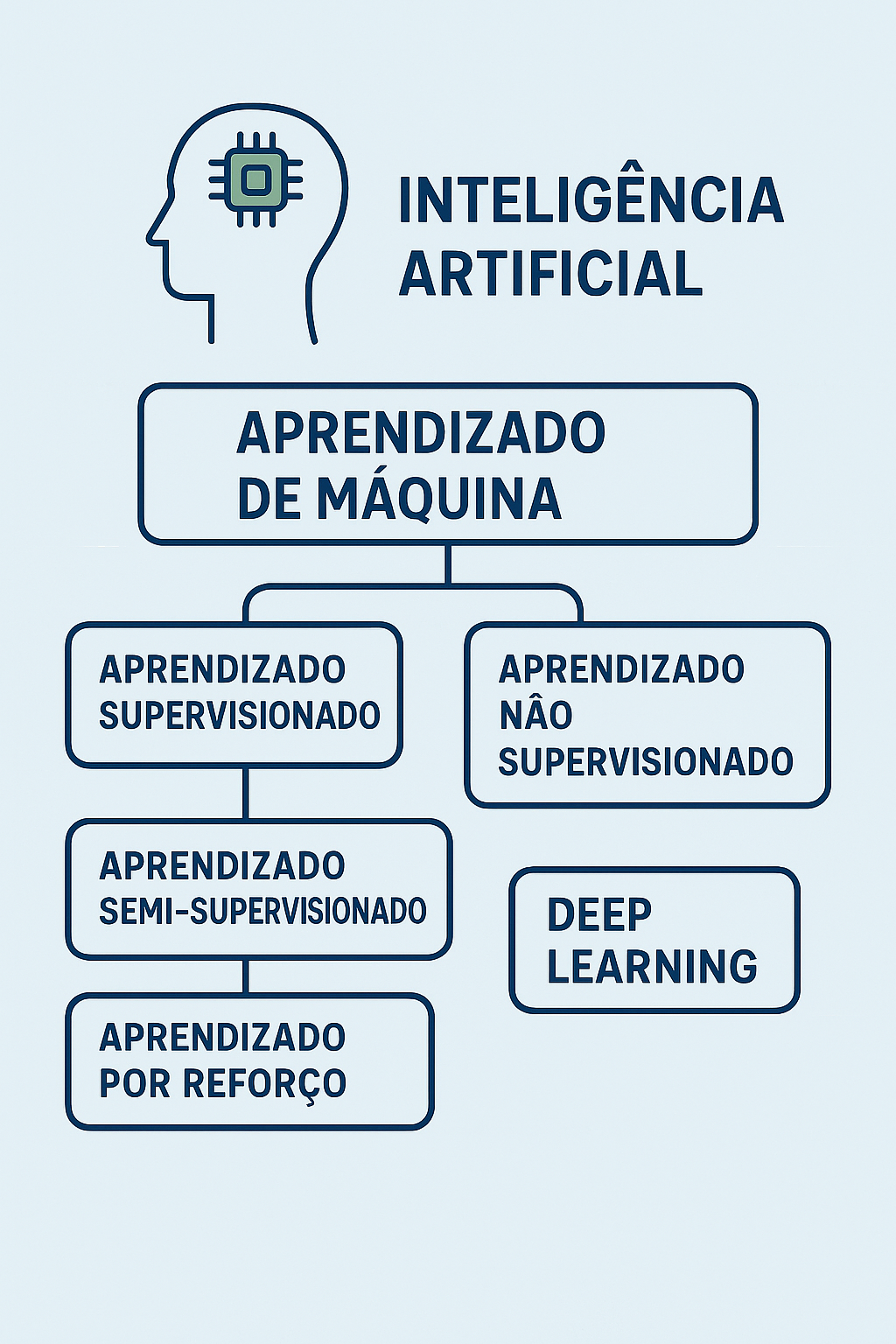

Um dos pilares da IA é o aprendizado de máquina (machine learning). Em vez de serem programadas com regras fixas, as máquinas aprendem a partir de dados. Imagine alimentar um sistema com milhares de fotos de gatos e cachorros: o algoritmo aprende a identificar padrões que diferenciam um do outro — e assim pode fazer previsões com base em novas imagens.

Dentro do aprendizado de máquina, há diferentes abordagens:

1. Aprendizado supervisionado

Nesse modelo, o algoritmo é treinado com dados rotulados — ou seja, com exemplos em que já se sabe a resposta. Por exemplo: imagens de frutas com a indicação “maçã” ou “banana”. A máquina aprende a associar os padrões das imagens às respostas corretas.

2. Aprendizado não supervisionado

Aqui, os dados não têm rótulos. O sistema analisa os dados em busca de padrões ou agrupamentos. Um exemplo é a segmentação de clientes com base em hábitos de consumo, mesmo sem saber quem comprou o quê exatamente.

3. Aprendizado semi-supervisionado

É um meio-termo: parte dos dados é rotulada, parte não. Esse modelo é útil quando rotular todos os dados seria caro ou inviável, mas ainda se quer direcionar o aprendizado da máquina.

4. Aprendizado por reforço (reinforcement learning)

Inspirado em como animais aprendem por tentativa e erro, esse modelo envolve um “agente” que interage com um ambiente e recebe recompensas ou punições. Um exemplo clássico são robôs aprendendo a andar ou algoritmos jogando xadrez.

5. Deep Learning (Aprendizado Profundo)

É uma subárea do aprendizado de máquina que usa redes neurais artificiais com muitas camadas (daí o termo “profundo”). É o que permite que IA reconheça vozes, rostos e até traduza idiomas com alta precisão. Essa técnica é o motor por trás de avanços como o ChatGPT e a geração de imagens por IA.

Entender esses conceitos é essencial para quem deseja acompanhar — e aproveitar — a revolução tecnológica da IA.

A inteligência artificial (IA) está cada vez mais presente no dia a dia das pessoas, influenciando desde as redes sociais, que escolhem quais conteúdos aparecem para cada usuário, até decisões mais sérias, como a aprovação de um financiamento bancário ou a avaliação de candidatos para uma vaga de emprego. No entanto, quando essas decisões são tomadas por algoritmos, surge uma grande preocupação: até que ponto essas máquinas respeitam os direitos humanos?

Para lidar com esses desafios, a União Europeia criou o Artificial Intelligence Act (AI Act), um conjunto de regras para garantir que a IA respeite direitos fundamentais, valores democráticos e princípios éticos. Um dos principais objetivos da lei é impedir que sistemas de IA prejudiquem pessoas de maneira injusta, reforcem discriminações ou violem a privacidade dos cidadãos.

A nova legislação está diretamente conectada à Convenção Europeia de Direitos Humanos (ECHR), que protege liberdades como o direito à privacidade, à igualdade e a um julgamento justo. No entanto, colocar essas proteções em prática não é tão simples, pois a IA pode operar como uma “caixa-preta”, tornando difícil entender por que um sistema tomou determinada decisão.

Para compreender os riscos e desafios da IA, é essencial entender três conceitos matemáticos e filosóficos que influenciam fortemente os algoritmos: viés, tendência e ruído.

O viés pode ser entendido como um desvio sistemático nas decisões tomadas por um sistema. No livro The Book of Why, Judea Pearl explica que viés é um problema que surge não apenas dos dados usados para treinar a IA, mas também da forma como os modelos matemáticos interpretam esses dados. Por exemplo, um algoritmo de recrutamento treinado com dados históricos pode aprender a associar determinados nomes ou bairros a candidatos de “baixo desempenho” simplesmente porque no passado as contratações foram feitas de forma desigual. O problema aqui não é apenas o dado, mas a maneira como o algoritmo usa correlações espúrias para tomar decisões.

Já a tendência pode ser entendida como a direção estatística predominante que um conjunto de dados assume. Se um banco utiliza um algoritmo para analisar milhares de pedidos de empréstimo e percebe que, historicamente, clientes de determinada faixa etária ou região atrasam mais os pagamentos, o sistema pode desenvolver uma tendência a rejeitar automaticamente solicitações semelhantes. O problema, como alerta Pearl, é que “correlação não implica causalidade”. Ou seja, apenas porque um grupo específico teve dificuldades no passado, isso não significa que todos os indivíduos desse grupo terão problemas no futuro.

Por fim, o conceito de ruído, abordado no livro Ruído de Daniel Kahneman, refere-se à variabilidade indesejada nas decisões. Em um experimento citado no livro, diferentes juízes tomaram decisões completamente diferentes para crimes semelhantes. No contexto da IA, ruído ocorre quando algoritmos tomam decisões inconsistentes porque foram treinados com dados imprevisíveis ou sem um critério sólido. Isso significa que, mesmo que um sistema seja projetado para minimizar viés, ele pode continuar sendo injusto simplesmente por ser inconsistente.

Esses três conceitos mostram que os algoritmos não são neutros. Eles refletem padrões preexistentes, reforçam desigualdades e, muitas vezes, tomam decisões sem uma lógica transparente. Isso torna essencial que legislações como o AI Act e a LGPD garantam maior transparência e supervisão sobre o uso da IA.

Imagine que você entra em um shopping e câmeras escondidas identificam seu rosto, analisam suas emoções e registram seu comportamento. Essas informações podem ser usadas para publicidade direcionada ou até para vigilância do governo. Esse tipo de tecnologia, conhecida como reconhecimento facial em tempo real, é uma das mais polêmicas quando se trata de IA e direitos humanos.

O Artigo 8 da ECHR protege o direito à privacidade, mas a IA pode colocar essa proteção em risco. Para minimizar abusos, o AI Act proíbe o reconhecimento facial em espaços públicos, exceto em situações específicas, como investigações criminais. No entanto, essa exceção gera preocupação: quem garante que esses sistemas não serão usados para vigilância em massa, como já ocorre na China?

Além disso, muitas empresas utilizam IA para analisar grandes volumes de dados pessoais. Por exemplo, aplicativos de saúde podem prever doenças futuras com base no seu histórico de navegação na internet ou em hábitos captados pelo seu smartwatch. Isso levanta a questão: as pessoas realmente consentiram com esse uso de dados ou foram apenas forçadas a aceitar os termos sem entender as consequências?

No Brasil, a Lei Geral de Proteção de Dados (LGPD) protege a privacidade dos cidadãos, mas não regula diretamente a IA. Isso significa que muitas das preocupações levantadas pelo AI Act ainda não foram abordadas pela legislação brasileira.

Para preencher essa lacuna, o Congresso discute o Projeto de Lei 2.338/23, que busca criar regras para IA no Brasil. Assim como o AI Act, o projeto propõe classificar os sistemas de IA conforme seu nível de risco e estabelecer requisitos de transparência e governança algorítmica.

Em fevereiro de 2025, a Cúpula de Ação sobre IA em Paris reuniu 58 países para discutir os impactos globais da IA, resultando na Declaração sobre Inteligência Artificial Inclusiva e Sustentável para as Pessoas e o Planeta. O documento propõe princípios como acessibilidade, ética e transparência, mas gerou controvérsia, pois Estados Unidos e Reino Unido optaram por não assinar, alegando preocupações com segurança nacional e governança global da IA.

Antes disso, em novembro de 2023, ocorreu a Cúpula de Segurança em IA no Reino Unido, onde a Declaração de Bletchley foi assinada por 28 países, incluindo China e EUA. O documento destacou a necessidade de cooperação internacional para evitar o uso malicioso da IA, alertando sobre riscos como terrorismo, crimes cibernéticos e impactos na estabilidade global.

O AI Act representa um avanço significativo na regulação da IA, garantindo que esses sistemas respeitem direitos humanos, transparência e justiça. No entanto, sua eficácia dependerá da aplicação rigorosa das regras e da criação de mecanismos de fiscalização robustos.

No Brasil, a discussão sobre IA ainda está em estágio inicial, mas as lições da União Europeia podem servir como um guia para desenvolver uma legislação equilibrada. Se bem implementada, a regulamentação da IA pode garantir inovação sem comprometer os direitos fundamentais, protegendo os cidadãos de abusos tecnológicos e decisões injustas de algoritmos invisíveis.

IAPP IA ACT

Março de 2025

A International Association of Privacy Professionals (IAPP) publicou análise intitulada “Os 10 Principais Impactos Operacionais do Regulamento Europeu de IA (EU AI Act)”, detalhando os efeitos significativos que essa legislação terá sobre organizações que trabalham com inteligência artificial (IA) na União Europeia:

1. Objeto, Definições, Principais Atores e Âmbito de Aplicação: apresenta os objetivos do regulamento, fornece definições de termos-chave, identifica os principais envolvidos e delimita seu escopo de aplicação.

2. Compreensão e Avaliação de Riscos: analisa a abordagem baseada em risco do regulamento, detalhando como os sistemas de IA são classificados em diferentes categorias de risco e quais obrigações correspondem a cada uma delas.

3. Obrigações para Provedores de Sistemas de IA de Alto Risco: especifica as responsabilidades impostas aos provedores de IA de alto risco, incluindo requisitos de conformidade e práticas de gestão de riscos.

4. Obrigações para Não-Provedores de Sistemas de IA de Alto Risco: aborda os deveres de entidades como distribuidores, importadores e usuários que não são provedores, mas estão envolvidos com sistemas de IA de alto risco.

5. Obrigações para Modelos de IA de Uso Geral: explora a posição do regulamento em relação a modelos de IA de uso geral, abordando desafios de classificação e as obrigações para seus provedores.

6. Governança: Autoridades da UE e Nacionais: explica a estrutura de governança estabelecida pelo regulamento, detalhando os papéis e responsabilidades das autoridades da UE e dos estados-membros na implementação e fiscalização.

7. Garantia de Conformidade para Diferentes Categorias de Risco: analisa os mecanismos necessários para assegurar que os sistemas de IA atendam aos padrões e regulamentações exigidos para cada categoria de risco.

8. Monitoramento Pós-Mercado, Compartilhamento de Informações e Fiscalização: Discute as obrigações relacionadas ao monitoramento dos sistemas de IA após sua entrada no mercado, incluindo protocolos de compartilhamento de informações e medidas de fiscalização.

9. Aproveitamento da Conformidade com o GDPR: fornece insights sobre como as organizações podem utilizar estruturas de conformidade já existentes do Regulamento Geral de Proteção de Dados (GDPR) para atender às exigências do AI Act.

10. Implementação e Aplicação Regulamentar: aborda os aspectos práticos da implementação e aplicação das disposições do regulamento dentro das organizações.

A integra do documento pode ser acessado em: https://iapp.org/media/pdf/resource_center/top_10_impacts_eu_ai_act.pdf

EU AI Act e a Regulamentação de IA no Brasil: Uma Perspectiva Comparativa

10 de janeiro de 2025

A Inteligência Artificial (IA) está transformando rapidamente diversas indústrias, levando governos a estabelecerem marcos regulatórios para equilibrar inovação e preocupações éticas. O EU AI Act e a regulamentação emergente da IA no Brasil representam duas abordagens distintas para a governança da IA, refletindo as prioridades regionais e tradições jurídicas de cada território.

O EU AI Act: Um Marco Regulatório Pioneiro

O EU AI Act é a primeira tentativa abrangente de regulamentar a IA em nível supranacional. Ele adota uma abordagem baseada no grau de risco, categorizando os sistemas de IA em risco inaceitável, alto risco, risco limitado e risco mínimo. Sistemas considerados inaceitáveis—como IA para pontuação social ou vigilância biométrica em tempo real—são proibidos. Já os sistemas de alto risco, incluindo aqueles usados na saúde, segurança pública e infraestrutura crítica, devem atender a requisitos rigorosos, como transparência, supervisão humana e governança robusta de dados.

Um aspecto-chave do EU AI Act é sua aplicação extraterritorial, ou seja, ele se aplica a qualquer sistema de IA que impacte cidadãos da UE, independentemente de onde tenha sido desenvolvido. Empresas que não cumprirem as normas podem enfrentar multas de até €35 milhões ou 7% do faturamento global. Essa regulamentação faz parte da estratégia digital da UE, reforçando princípios de privacidade, responsabilidade e proteção ao consumidor.

A Regulamentação de IA no Brasil: Um Marco em Construção

No Brasil, a regulamentação da IA ainda está em fase inicial. O Marco Legal da Inteligência Artificial está em discussão no Congresso e se inspira tanto no EU AI Act quanto na Lei Geral de Proteção de Dados (LGPD). A proposta enfatiza ética, transparência e direitos humanos, com o objetivo de prevenir discriminação e garantir a responsabilização dos algoritmos.

Diferente do EU AI Act, a abordagem brasileira permanece mais flexível, permitindo que setores específicos definam suas próprias regras para governança da IA. A ANPD (Autoridade Nacional de Proteção de Dados) deve desempenhar um papel essencial na fiscalização de aplicações de IA que envolvem dados pessoais. No entanto, ainda há desafios a serem enfrentados, como a definição de responsabilidade por danos causados pela IA e a criação de um ambiente regulatório que incentive a inovação sem impor barreiras excessivas.

Perspectivas Comparativas

Embora ambos os marcos regulatórios priorizem avaliação de riscos e proteção de direitos fundamentais, o EU AI Act é mais detalhado e de aplicação obrigatória, enquanto o modelo brasileiro ainda está em desenvolvimento e busca equilibrar regulamentação e crescimento econômico. À medida que a IA continua a moldar a sociedade, a convergência regulatória e a cooperação internacional serão essenciais para uma governança responsável da inteligência artificial.

A crescente importância da proteção de dados pessoais tem levado empresas a buscar soluções eficazes para garantir o cumprimento das legislações de privacidade, como a LGPD (Lei Geral de Proteção de Dados Pessoais) no Brasil e o GDPR (Regulamento Geral sobre a Proteção de Dados) na União Europeia. Um dos principais papéis na implementação e manutenção dessas normas é o do DPO (Data Protection Officer), ou encarregado de proteção de dados. A nomeação de um DPO qualificado é uma exigência legal e estratégica para empresas que lidam com dados pessoais, com foco não apenas na conformidade regulatória, mas também na mitigação de riscos comerciais, trabalhistas e de conflitos de interesse.

O DPO e o Regulamento da ANPD

No Brasil, a ANPD (Autoridade Nacional de Proteção de Dados) estabelece as diretrizes para a atuação do encarregado de dados pessoais, conforme o artigo 41 da LGPD. O DPO tem a responsabilidade de garantir que a empresa esteja em conformidade com os princípios da LGPD, ajudando na elaboração e implementação de políticas internas, monitoramento de processos e treinamentos. O DPO também atua como canal de comunicação entre a empresa, os titulares dos dados e a ANPD, promovendo transparência e confiança.

LGPD vs GDPR: Similaridades e Desafios

Embora a LGPD e o GDPR compartilhem objetivos semelhantes, como a proteção da privacidade e o direito dos titulares sobre seus dados, as diferenças entre as duas legislações exigem um entendimento detalhado. O DPO, portanto, deve estar preparado para lidar com as nuances de cada regulamento. A principal semelhança é a obrigatoriedade de nomear um DPO em determinadas situações, como o tratamento em grande escala de dados sensíveis ou a monitorização regular e sistemática de indivíduos. No entanto, as penalidades e as exigências específicas de relatórios e auditorias podem variar, o que exige uma atuação ainda mais estratégica do DPO.

Mitigando Riscos Comerciais e Trabalhistas

No contexto comercial, o DPO desempenha um papel crucial na prevenção de incidentes relacionados à violação de dados, que podem resultar em danos à reputação da empresa, perda de confiança dos clientes e, em última instância, sanções financeiras. A conformidade com a LGPD e o GDPR também traz benefícios tangíveis, como a melhoria da imagem da empresa no mercado, a atração de clientes mais conscientes sobre a proteção de dados e a vantagem competitiva de ser uma empresa que respeita os direitos de privacidade.

Além disso, o DPO também contribui para a mitigação de riscos trabalhistas. Ao assegurar que o tratamento de dados pessoais de funcionários esteja em conformidade com as legislações, ele evita litígios trabalhistas relacionados à privacidade e uso indevido de informações pessoais. O DPO é essencial para estabelecer políticas claras sobre o tratamento de dados dos colaboradores, reduzindo o risco de ações judiciais por violações de privacidade.

Conflitos de Interesse: Como o DPO Prevê e Gerencia

O DPO deve ser imparcial e independente, o que implica a necessidade de gerenciar possíveis conflitos de interesse. Ele deve atuar de maneira a garantir que as práticas de tratamento de dados não sejam influenciadas por pressões externas ou interesses internos que possam comprometer a proteção dos dados pessoais. A separação clara das funções de DPO e outras áreas da empresa (como vendas ou marketing) é crucial para assegurar que o encarregado de dados possa atuar com autonomia e sem qualquer viés comercial ou de gestão.

A Importância de um DPO Profissional e Qualificado

Empresas que buscam conformidade com as normativas de proteção de dados devem investir na contratação de um DPO qualificado, capaz de atender às exigências da LGPD, do GDPR e da ANPD, enquanto protege os interesses da empresa e dos titulares de dados. A atuação do DPO não deve ser vista apenas como uma exigência legal, mas como uma oportunidade estratégica para fortalecer a reputação da empresa, mitigar riscos comerciais e trabalhistas, e evitar conflitos de interesse que possam prejudicar sua imagem e suas operações.

Em resumo, a nomeação e atuação eficiente de um DPO são fundamentais para garantir o cumprimento das normativas de proteção de dados, proteger a empresa contra riscos legais e financeiros, e assegurar uma gestão ética e transparente no tratamento de informações sensíveis. Isso não apenas fortalece a posição da empresa no mercado, mas também promove a confiança do público, elemento essencial para o sucesso a longo prazo.